تحليل البيانات الضخمة وأمن الذكاء الإصطناعي

عناصر الموضوع

1- تعريف البيانات الضخمة

2- لماذا تكامل البيانات الضخمة مهم؟

3- فوائد تحليل البيانات الضخمة

4- أهم أدوات الذكاء الإصطناعي في تحليل البيانات العملاقة

5- أمثلة وحالات إستخدام الذكاء الإصطناعي للبيانات الضخمة

في العصر الحالي، يعتبر تحليل البيانات الضخمة (Big Data) وأمن الذكاء الاصطناعي من أبرز الأدوات التي ساهمت في تطوير الكثير من المجالات وتحقيق الإنجاز في الأبحاث العلمية والأعمال التجارية وغيرها. وذلك يعود إلى قدرتها على تحويل كميات هائلة من البيانات الضخمة إلى معلومات وبيانات قيمة، وذلك لاتخاذ القرارات الذكية.

1- تعريف البيانات الضخمة

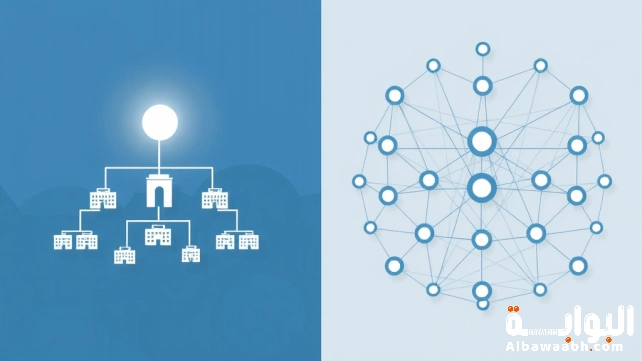

يعد تحليل البيانات الضخمة وأمن الذكاء الاصطناعي أساس المعلومات التي نبحث عنها كل يوم – تضم كميات هائلة من البيانات الموجودة في حواسيبنا وأجهزتنا المحمولة وأيضا أجهزة الاستشعار الآلية.

ولذلك يتم استخدام هذه البيانات الضخمة من قبل الشركات لتحسين القرارات والعمليات وطرح خدمات وتجارب تركز بشكل مباشر على العملاء.

أيضا تعرف البيانات الضخمة بأنها كبيرة الحجم ولكن ليس فقط بسبب حجمها، وإنما بسبب طبيعتها المعقدة والمتنوعة. وفي الغالب ما تتعدي سعة أنماط البيانات التقليدية لالتقاطها ومعالجتها وإدارتها.

البيانات الضخمة يمكن أن تأتي من أي مكان أو أي شيء على وجه الأرض ولذلك يمكننا مراقبته رقميًا من خلال أجهزة إنترنت الأشياء (IoT) وأقمار الطقس الصناعية وكاميرات المرور وأيضا وسائل التواصل الاجتماعي وهذه مجرد أمثلة قليلة من مصادر البيانات التي يتم استخلاصها وتحليلها لجعل المؤسسات أكثر دقة ومرونة وتنافسية. [1]

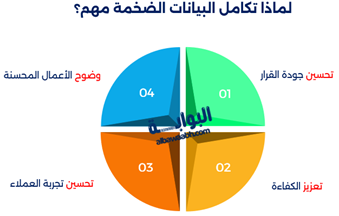

2- لماذا تكامل البيانات الضخمة مهم؟

تتميز البيانات الضخمة بأنها تصل في اشكال مختلفة، فيكون من الصعب استخدامها وتحليلها بشكل جيد. ومن هنا تتكامل البيانات الضخمة، حيث يتم دمجها معًا من أجل ضمان مصداقيتها وتوقيتها ودقتها. وبدون ضمان التكامل الجيد، من المحتمل أننا سنقع في بحر من قطع المعلومات المعقدة.

يوفر تحليل البيانات الضخمة وأمن الذكاء الاصطناعي تطورات جوهرية لعملك وهي كالآتي:

- تحسين جودة القرار: يتيح تكامل البيانات الضخمة رؤية واضحة للبيانات، حيث أنه يسمح للمؤسسات اتخاذ قرارات دقيقة بناءً على معلومات حديثة.

- تعزيز الكفاءة: يتيح للمؤسسات توفير الجهد والوقت والمال، وبالتالي تقليل مخاطر الأخطاء المترتبة على إدخال البيانات يدويًا ويكون ذلك من خلال أتمتة تكامل البيانات العملية.

- تحسين تجربة العملاء: يسمح تكامل البيانات الضخمة للشركات فهم أفضل لعملائها. ويترتب عليه حملات تسويقية مستهدفة، وبالتالي تحسين خدمة العملاء، وزيادة ولائهم.

- وضوح الأعمال المحسنة: يتيح للمؤسسات استخلاص رؤى أعمق لعملياتها وتحديد الفرص والاتجاهات والمخاطر المحتملة وذلك من خلال جمع ودمج البيانات من مصادر مختلفة. [2]

3- فوائد تحليل البيانات الضخمة

- تعتبر البيانات الضخمة من أهم الأدوات في العصر الرقمي، ولذلك تتيح فرصًا كبيرة للاستفادة من البيانات المتزايدة بشكل هائل واستخراج رؤى حديثة. كما يساعد تحليل البيانات الضخمة في تعزيز الأداء واتخاذ القرارات الاستراتيجية بشكل فعال ودقيق.

- قدرتها على استخراج الاتجاهات والأنماط المعقدة. وذلك من خلال استخدام نماذج وأنماط التعلم الآلي، وأيضا تحليل كميات كبيرة من البيانات واستخلاص أنماط وسلوك المستهلكين وخطوات السوق، وبالتالي تستطيع المؤسسات خلق القرارات الاستراتيجية الدقيقة والصائبة.

- يؤدي تحليل البيانات الضخمة إلى تعزيز أداء الأعمال. وذلك عن طريق فهم الأنماط وعمليات الأعمال التي تؤثر في الأداء، يمكن للمؤسسات تحديد النماذج التي تحتاج إلى تحسين وتحديد الإجراءات اللازمة لتحقيق النتائج الدقيقة.

- يتيح تحليل البيانات الضخمة في تعزيز كفاءة العمليات وتوفير التكاليف وزيادة الإنتاجية.

وبناءاً عليه، تستطيع الشركات تحليل البيانات الضخمة وأمن الذكاء الاصطناعي من خلال استخراج البيانات بشكل دقيق وخلق قرارات استراتيجية صائبة وتطوير أداء الأعمال. ولذلك نهج الذكاء الاصطناعي يتيح للشركات التنافس في سوق الأعمال. [3]

4- أهم أدوات الذكاء الإصطناعي في تحليل البيانات العملاقة

سنعرض قائمة بأهم الأدوات المستخدمة في تحليل البيانات الضخمة وأمن الذكاء الاصطناعي:

نموذج Hadoop

يعتبر نموذج عمل مفتوح المصدر يُقوم بتخزين ومعالجة البيانات الضخمة. ويعتمد علي نمط التخزين الموزع ويشمل نظام ملفات موزع (HDFS) ونظام اخر لمعالجة البيانات (MapReduce) ..

نموذج Apache Spark

يعتبر نموذج عمل مفتوح المصدر يعمل علي معالجة البيانات الضخمة بسرعة تفوق سرعة Hadoop ولذلك يدعم Spark التحليل البياني والتحليل الإحصائي ومعالجة البيانات الدقيقة والتعلم الآلي العميق.

Python ومكتباته العلمية

هو لغة برمجة مشهورة في تحليل البيانات. تسمح مكتبات مثل Matplotlibو NumPy وPandas وSciPy وScikit- Learn إجراء العمليات المرتبطة بتحليل البيانات والتعلم الآلي.

TensorFlow وKeras

هما إطاري عمل مفتوحي المصدر يعملان على تطوير أنماط التعلم العميق. ويُستخدمان على نطاق واسع في تصميم وتدريب الشبكات العصبية العميقة لتحليل البيانات الضخمة.

PyTorch

هو إطار عمل لتدريب وتصميم الشبكات العصبية العميقة. كما انه يمتاز بقوته في مجال التعلم العميق ويُستخدم في التطبيقات الصناعية والبحثية.

R

هو بيئة تحليل بيانات ولغة برمجة تُستخدم على نطاق واسع في تحليل البيانات الإحصائية والتصور والتحليل الرياضي. كما انه يُستخدم بشكل خاص في مجالات البحث والإحصاء.

Tableau

هو أداة تصور البيانات تسمح للمستخدمين عمل لوحات معلومات بفعالية وتصور البيانات بشكل بصري. كما انه يستخدم لاستخراج وتصور البيانات الضخمة بسهولة.

Apache Flink

هو إطار عمل مفتوح المصدر يعمل على معالجة البيانات الدقيقة بشكل سريع. ولذلك يمكن استخدامه في تحليل البيانات العملاقة التي تأتي بشكل متكرر ومتسلسل.

SAS

هو برنامج تحليل بيانات متقدم يُستخدم في الكثير من الصناعات لتنفيذ تحليل البيانات وخلق وتوليد التقارير وكذلك تطوير أنماط التوقعات.

Microsoft Power BI

هو أداة تحلل وتصور البيانات، تُستخدم لإنشاء تقارير تفاعلية ولوحات معلومات تبين البيانات بشكل بصري. وتستخدم أيضاً في تحليل البيانات واتخاذ القرارات الصائبة. [4]

5- أمثلة وحالات إستخدام الذكاء الإصطناعي للبيانات الضخمة

تمارس تحليل البيانات الضخمة وأمن الذكاء الاصطناعي دورًا مهمًا في التحليلات التنبؤية للبيانات، وذلك عن طريق التكنولوجيا لأتمتة العملية وتسريعها. وبالتالي يقلل من الأخطاء داخل العملية والجهد والوقت المستغرق من جمع البيانات من أجل الحصول على المعلومات الصائبة، وأيضاً يوفر التكاليف.

يمكن للمؤسسات في مختلف الصناعات الاستفادة بشكل كبير من الذكاء الاصطناعي والبيانات الضخمة، حيث تمكنها من اتخاذ قرارات صائبة. وفيما يلي بعض الأمثلة والحالات للاستخدامات العديدة للذكاء الاصطناعي في البيانات الضخمة:

- الخدمات المالية: تسمح المؤسسات المالية الذكاء الاصطناعي لمعرفة الأنماط والشذوذ في البيانات، حيث يساعدها في استخراج المخاطر والاحتيال. كما تستفاد من برامج المحادثة التي تعمل بالذكاء الاصطناعي لخدمة العملاء، ونماذج التعلم الآلي لمعرفة مخاطر الائتمان، والتداول القائم على الخوارزميات فهي أمثلة شائعة.

- التجزئة: تتيح أدوات الذكاء الاصطناعي التنبؤ بأنماط المستهلكين لتحسين المخزون وابتكار المنتجات. كما يستخدم الكثير من تجار التجزئة البيانات المدعومة بالذكاء الاصطناعي لتعزيز التوصيات المخصصة للعملاء.

- التسويق: يساعد الذكاء الاصطناعي المسوقين على فهم سلوك العملاء وعواطفهم بشكل أفضل لتقسيم الجماهير وتقديم تسويق بناءً على الأساليب المفضلة أو تفاعل العملاء السابقين أو الاهتمامات الشخصية أو تاريخ الشراء.

- الرعاية الصحية: يستطيع الذكاء الاصطناعي تحليل مخططات المرضى والصور وغيرها من البيانات لمساعدة المتخصصين في التشخيص. كما يمكنه تعزيز خيارات علاج مخصصة والتنبؤ بنتائج المرضى.

- التصنيع: تساعد البيانات الضخمة والذكاء الاصطناعي على تطوير أنظمة مراقبة الجودة الحالية لتحسين جودة المنتج بشكل كبير. علاوة على ذلك تقليل وقت تعطل المعدات عن طريق التنبؤ بالصيانة وأعطال المعدات والتنبؤ بالاتجاهات التي ستؤثر على سلسلة التوريد.

- تكنولوجيا المعلومات: يعتمد متخصصو تكنولوجيا المعلومات على الذكاء الاصطناعي في البيانات العملاقة لمراقبة الأجهزة والبنية التحتية التقنية، وكذلك التنبؤ باحتياجات الصيانة، وتحديد مخاطر الأمن السيبراني لحجب الهجمات وانقطاع الخدمة. [5]

ببساطة، يعتبر تحليل البيانات الضخمة وأمن الذكاء الاصطناعي قادر على أن يتعامل مع البيانات الضخمة والمختلفة بشكل دقيق وسريع وكذلك تعزيز وتحسين النتائج والحصول على القرارات الصائبة.

المراجع

- SAPتعريف البيانات الضخمة - بتصرف

- Astera Softwareلماذا تكامل البيانات الضخمة مهم؟ - بتصرف

- Diamondفوائد تحليل البيانات الضخمة - بتصرف

- DiEconomyأهم أدوات الذكاء الإصطناعي في تحليل البيانات العملاقة - بتصرف

- DOMOأمثلة وحالات إستخدام الذكاء الإصطناعي للبيانات الضخمة - بتصرف

مشاركة المقال

وسوم

هل كان المقال مفيداً

الأكثر مشاهدة

ذات صلة

أهمية الأمن السيبراني في العصر الرقمي: كيف تحمي...

كيف تعيد Vidnoz تشكيل التعبير المرئي عبر الذكاء...

أحدث الابتكارات التقنية لعام 2025 وتأثيرها على حياتنا

الحوسبة السحابية كيف تغير طريقة تخزين البيانات وإدارتها؟

تقنية الطباعة الحيوية ثلاثية الأبعاد: المستقبل في الطب

تطور الحوسبة ألكموميه وأثرها على التكنولوجيا المستقبلية

برمجة التطبيقات المحمولة: أساسيات وأدوات للمبتدئين

إنترنت الأشياء (IoT): الأجهزة الذكية في حياتنا اليومية

أمن المعلومات في المؤسسات: استراتيجيات وتحديات

تقنيات الواقع الافتراضي والواقع المعزز في التعليم والتدريب

التشفير الرقمي: أساسيات وحماية البيانات في العصر الرقمي

السيارات ذاتية القيادة: كيف تغير مستقبل التنقل؟

البرمجة بدون أكواد: كيف تبني تطبيقاً بدون معرفة...

أفضل تطبيقات الهواتف الذكية لإدارة الوقت وزيادة الإنتاجية